Featherless

Featherless - Serverless LLM

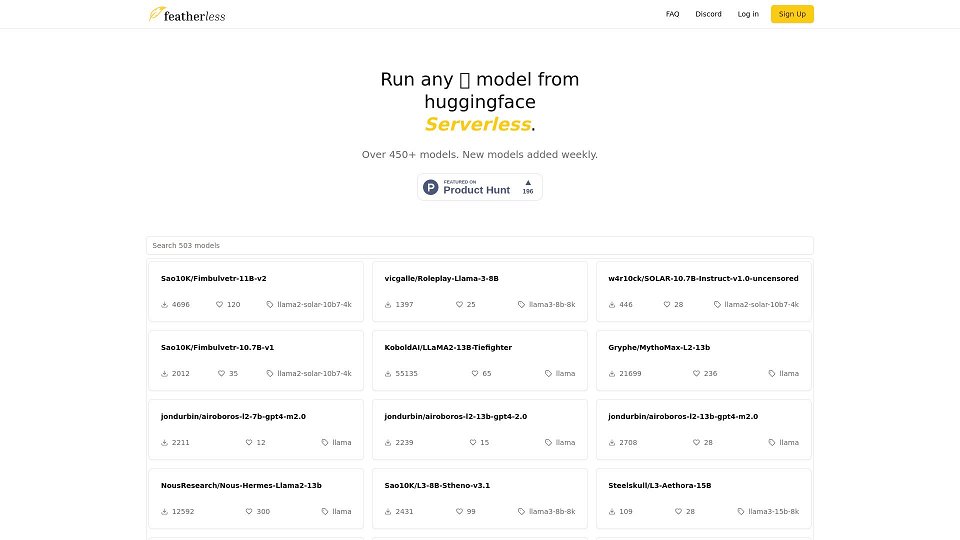

Featherless - Die neuesten LLM-Modelle, serverless und einsatzbereit auf Anfrage.

Featherless Einführung

Featherless ist ein KI-Modellanbieter, der abonnementbasierten Zugriff auf eine Vielzahl von großen Sprachmodellen (LLMs) bietet, die auf Hugging Face gehostet werden. Es bietet eine serverlose Plattform, auf der Benutzer über eine OpenAI-kompatible API mit diesen Modellen interagieren können. Featherless konzentriert sich darauf, kostengünstigen Zugriff auf leistungsstarke LLMs wie LLaMA-3 und QWEN-2 zu bieten, die dank FP8-Quantisierung eine hohe Inferenzgeschwindigkeit aufweisen. Sie legen Wert auf den Schutz der Privatsphäre der Benutzer, indem sie keine Benutzerinteraktionen protokollieren. Featherless unterstützt und trägt auch zur Open-Source-KI-Entwicklung bei, wobei ein Teil seines Umsatzes für das Training und die Skalierung mehrsprachiger und erschwinglicher Modelle verwendet wird.

Featherless Anwendungsfälle

Zugriff auf und Experimentieren mit verschiedenen LLMs

Entwicklung von KI-gesteuerten Anwendungen mit einer OpenAI-kompatiblen API

Ausführung von KI-Modellen für persönliche Projekte ohne teure Hardware

Nutzung von LLMs für Aufgaben wie Textgenerierung, Chatbots und Codegenerierung

Kernfunktionen von Featherless

Unbegrenzte persönliche Nutzung*

Immer größer werdende Liste von Community-Modellen, wöchentlich aktualisiert

Voller OpenAI-kompatibler API-Zugriff

Zugriff auf bis zu 15 Mrd. Modelle (Basic) / 72 Mrd. Modelle (Premium)

Private, sichere und anonyme Nutzung - keine Protokollierung

Featherless Häufig gestellte Fragen

Was ist Featherless?

Featherless ist ein KI-Modellanbieter, der unseren Abonnenten Zugriff auf eine ständig wachsende Bibliothek von Hugging Face-Modellen bietet. Featherless: Weniger Aufwand, weniger Mühe. Jetzt starten.

Was kostet es?

Wir bieten zwei Preismodelle für 10 und 25 US-Dollar pro Monat an. Wenn die gleichzeitigen Anforderungen für echte persönliche Nutzung zu restriktiv sind, kontaktieren Sie uns bitte über unseren <a>Discord</a>.

Werden meine Protokolle gespeichert?

Nein. Als datenschutzorientierter Dienst protokollieren wir keine Ihrer Chats, Eingaben oder Vervollständigungen.

Welche Modellarchitektur wird unterstützt?

Derzeit unterstützen wir auf LLaMA-3 basierende Modelle, einschließlich LLaMA-3 und QWEN-2. Beachten Sie, dass QWEN-2-Modelle nur bis zu einer Kontextlänge von 16.000 unterstützt werden. Wir planen, weitere Architekturen in unsere unterstützte Liste aufzunehmen.

Wie füge ich neue Modelle hinzu?

Schreiben Sie uns in unserem <a>Discord</a>. Wir nehmen kontinuierlich neue Modelle auf, sobald sie auf Hugging Face verfügbar sind. Mit unserem Wachstum streben wir an, diesen Prozess zu automatisieren, um <em>alle</em> öffentlich verfügbaren Hugging Face-Modelle mit kompatibler Architektur einzuschließen.

Wie unbegrenzt ist unbegrenzt?

Solange Sie abonniert bleiben, gibt es keine zeitliche Begrenzung für die Nutzung des Modells. Um eine faire individuelle Nutzung des Kontos zu gewährleisten, sind gleichzeitige Anfragen gemäß dem von Ihnen gewählten Plan begrenzt. Die Ausgabe erfolgt mit einer Geschwindigkeit von 10-40 Tokens pro Sekunde, abhängig vom Modell und der Größe der Eingabeaufforderung.

Wie kann ich Kontakt aufnehmen?

Treten Sie unserem <a>Discord</a> bei oder besuchen Sie uns auf <a>r/SillyTavernAI</a>.

Verwenden Sie quantisierte Modelle?

Ja, wir verwenden FP8-Quantisierung. Nach Rücksprache mit der Community haben wir festgestellt, dass dieser Ansatz die Ausgabequalität beibehält und die Inferenzgeschwindigkeit erheblich verbessert.

Wie können Sie so viele Modelle ausführen?

Im Herzen der Plattform befindet sich unser benutzerdefinierter Inferenz-Stack, mit dem wir dynamisch

Benutzer, die Featherless verwenden

KI-Entwickler

Forscher

Hobbyisten

Einzelpersonen und Unternehmen, die nach erschwinglichen und zugänglichen LLM-Lösungen suchen