Featherless

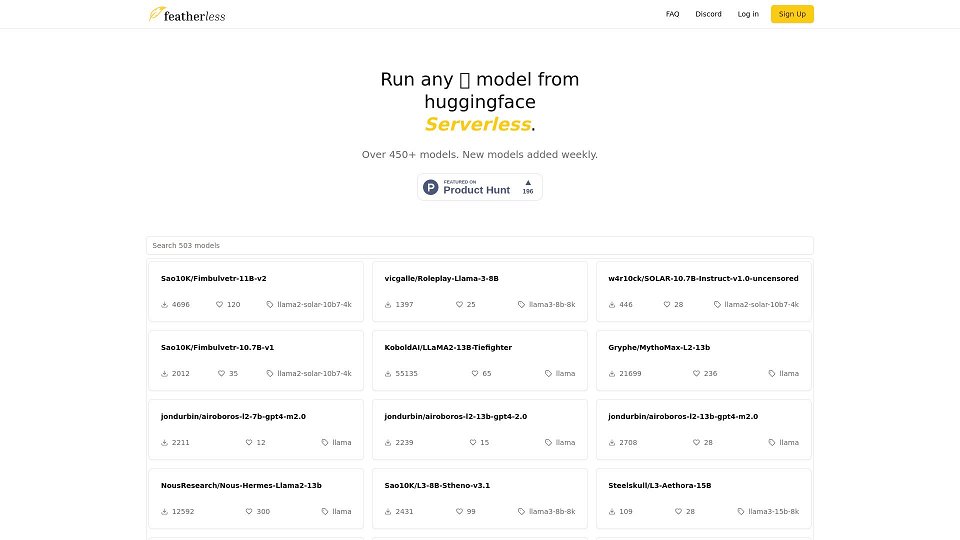

Featherless - 无服务器LLM

Featherless - 最新的LLM模型,无服务器且可按需使用。

Featherless 介绍

Featherless是一个AI模型提供商,提供基于订阅的访问Hugging Face托管的各种大型语言模型(LLMs)的平台。它提供了一个无服务器平台,用户可以通过OpenAI兼容的API与这些模型进行交互。Featherless专注于提供经济高效的强大LLMs访问,包括LLaMA-3和QWEN-2,通过FP8量化实现高推理速度。他们通过不记录任何用户交互来保护用户隐私。Featherless还支持和贡献于开源AI开发,其部分收入用于训练和扩展多语言和经济实惠的模型。

Featherless 使用案例

访问和尝试各种LLMs

使用OpenAI兼容的API开发基于AI的应用程序

在个人项目中运行AI模型,无需昂贵的硬件

利用LLMs进行文本生成、聊天机器人和代码生成等任务

Featherless 核心功能

无限个人使用*

不断增长的社区模型列表,每周更新

完全兼容OpenAI的API访问

访问高达15B模型(基础版)/ 72B模型(高级版)

私密、安全和匿名使用 - 无日志

Featherless 常见问题

Featherless是什么?

Featherless是一个AI模型提供商,为我们的订阅用户提供不断扩大的Hugging Face模型库。 Featherless:更少的麻烦,更少的努力。立即开始。

费用是多少?

我们提供两种价格计划,每月10美元和25美元。 如果并发限制对真正的个人使用来说过于限制,请通过我们的<a>discord</a>与我们联系。

我的日志被存储吗?

不会。作为一个注重隐私的服务,我们不会记录您的聊天记录、提示或完成内容。

支持哪种模型架构?

目前,我们支持基于LLaMA-3的模型,包括LLaMA-3和QWEN-2。 请注意,QWEN-2模型仅支持最多16,000个上下文长度。 我们计划很快将更多架构添加到我们的支持列表中。

如何添加新模型?

在我们的<a>discord</a>上与我们联系。 我们会不断添加新模型,以适应Hugging Face上可用的所有兼容架构的公开模型。 随着我们的发展,我们计划自动化这个过程。

无限使用有多无限?

只要您保持订阅,模型使用没有时间限制。 为了确保公平的个人账户使用,同时请求根据您选择的计划进行限制。 输出速度为每秒10-40个标记,具体取决于模型和提示的大小。

如何联系你?

加入我们的<a>discord</a>或在<a>r/SillyTavernAI</a>上找到我们

您是否运行量化模型?

是的,我们使用FP8量化。 在与社区咨询后,我们发现这种方法在显著提高推理速度的同时保持了输出质量。

您是如何运行这么多模型的?

在平台的核心是我们的自定义推理堆栈,我们可以动态地

使用Featherless的用户

AI开发者

研究人员

爱好者

寻找经济实惠和可访问LLM解决方案的个人和企业