Featherless

Featherless - Serveur LLM sans plumes

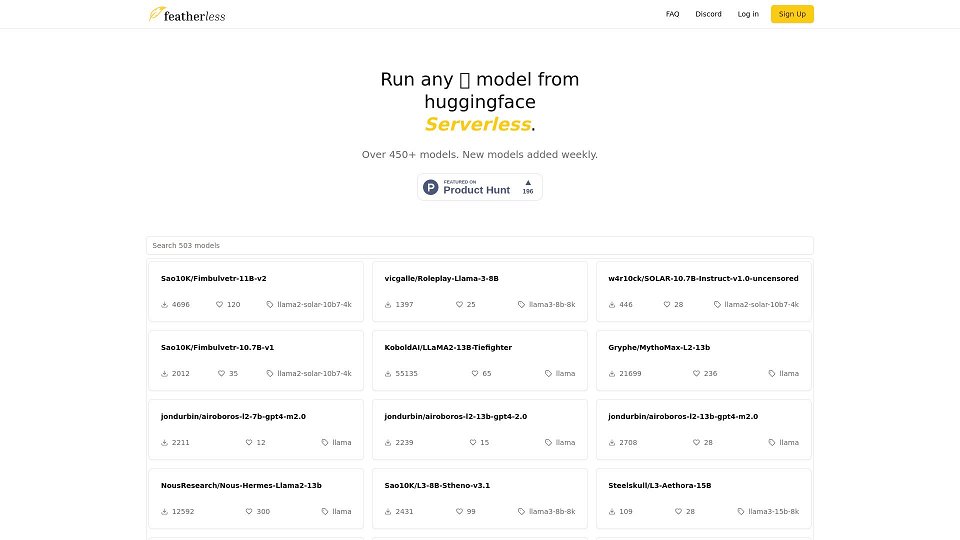

Featherless - Les derniers modèles LLM, sans serveur et prêts à être utilisés sur demande.

Introduction de Featherless

Featherless est un fournisseur de modèles d'IA qui propose un accès basé sur abonnement à une grande variété de grands modèles de langage (LLM) hébergés sur Hugging Face. Il fournit une plateforme sans serveur où les utilisateurs peuvent interagir avec ces modèles via une API compatible avec OpenAI. Featherless se concentre sur l'accès économique à des LLM puissants, notamment LLaMA-3 et QWEN-2, avec des vitesses d'inférence élevées grâce à la quantification FP8. Ils accordent la priorité à la confidentialité des utilisateurs en ne journalisant aucune interaction utilisateur. Featherless prend également en charge et contribue au développement d'IA open source, une partie de ses revenus étant consacrée à la formation et à la mise à l'échelle de modèles multilingues et abordables.

Cas d'utilisation de Featherless

Accéder et expérimenter différents LLM

Développer des applications alimentées par l'IA en utilisant une API compatible avec OpenAI

Exécuter des modèles d'IA pour des projets personnels sans avoir besoin de matériel coûteux

Utiliser des LLM pour des tâches telles que la génération de texte, les chatbots et la génération de code

Caractéristiques principales de Featherless

Utilisation personnelle illimitée*

Liste constamment mise à jour de modèles communautaires

Accès complet à une API compatible avec OpenAI

Accès à des modèles jusqu'à 15 milliards (Basic) / 72 milliards (Premium)

Utilisation privée, sécurisée et anonyme - pas de journaux

Questions fréquentes de Featherless

Qu'est-ce que Featherless ?

Featherless est un fournisseur de modèles d'IA qui offre à nos abonnés un accès à une bibliothèque en constante expansion de modèles Hugging Face. Featherless : Moins de tracas, moins d'efforts. Commencez maintenant.

Combien cela coûte-t-il ?

Nous proposons deux plans tarifaires à 10 et 25 dollars par mois. Si les limites de concurrence sont trop restrictives pour une utilisation personnelle légitime, veuillez nous contacter via notre <a>discord</a>.

Mes journaux sont-ils stockés ?

Non. En tant que service axé sur la confidentialité, nous ne conservons aucun de vos chats, prompts ou complétions.

Quelle architecture de modèle est prise en charge ?

À l'heure actuelle, nous prenons en charge les modèles basés sur LLaMA-3, notamment LLaMA-3 et QWEN-2. Notez que les modèles QWEN-2 sont pris en charge jusqu'à une longueur de contexte de 16 000. Nous prévoyons d'ajouter bientôt d'autres architectures à notre liste de modèles pris en charge.

Comment puis-je ajouter de nouveaux modèles ?

Contactez-nous sur notre <a>discord</a>. Nous intégrons en continu de nouveaux modèles au fur et à mesure de leur disponibilité sur Hugging Face. À mesure que nous grandissons, nous prévoyons d'automatiser ce processus afin d'inclure <em>tous</em> les modèles Hugging Face disponibles publiquement avec une architecture compatible.

À quel point est-il illimité ?

Tant que vous restez abonné, il n'y a pas de limite de temps d'utilisation du modèle. Pour garantir une utilisation équitable du compte individuel, les demandes concurrentes sont limitées en fonction du plan que vous avez sélectionné. La sortie est livrée à une vitesse de 10 à 40 jetons par seconde, en fonction du modèle et de la taille du prompt.

Comment puis-je vous contacter ?

Rejoignez notre <a>discord</a> ou venez nous trouver sur <a>r/SillyTavernAI</a>

Utilisez-vous des modèles quantifiés ?

Oui, nous utilisons la quantification FP8. Après consultation de la communauté, nous avons constaté que cette approche maintient la qualité de la sortie tout en améliorant considérablement les vitesses d'inférence.

Comment pouvez-vous exécuter autant de modèles ?

Au cœur de la plateforme se trouve notre pile d'inférence personnalisée, grâce à laquelle nous pouvons dynamiquement

Utilisateurs de Featherless

Développeurs d'IA

Chercheurs

Amateurs

Particuliers et entreprises à la recherche de solutions LLM abordables et accessibles