無羽

無羽 - 無伺服器LLM

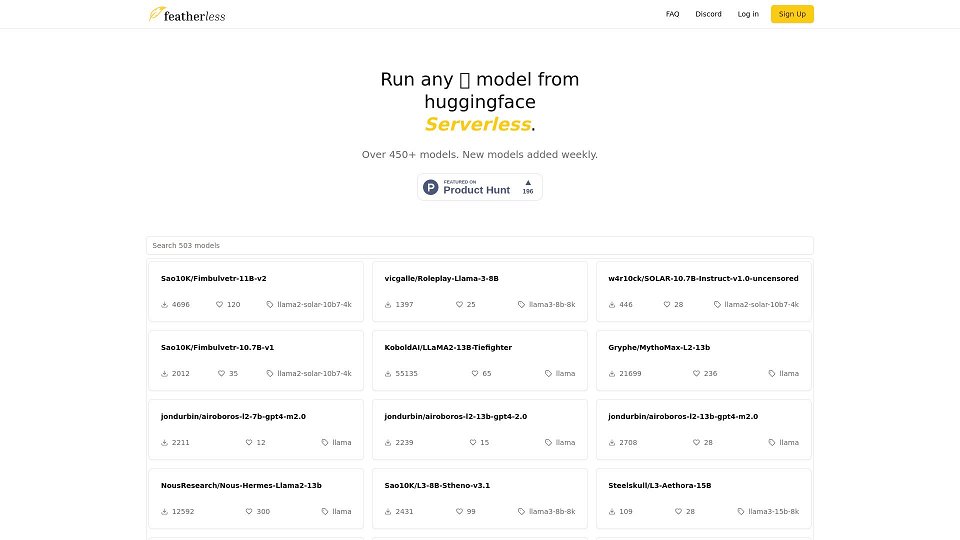

無羽 - 最新的LLM模型,無伺服器並隨時準備使用。

無羽 介紹

無羽是一個AI模型提供者,提供基於訂閱的方式來訪問Hugging Face上的各種大型語言模型(LLMs)。它提供了一個無伺服器平台,用戶可以通過OpenAI兼容的API與這些模型進行交互。無羽專注於提供具有高推理速度的高性價比的強大LLMs,包括LLaMA-3和QWEN-2,並且使用FP8量化。他們通過不記錄任何用戶交互來優先考慮用戶隱私。無羽還支持並貢獻於開源AI開發,其中一部分收入將用於訓練和擴展多語言和可負擔的模型。

無羽 使用案例

訪問和嘗試各種LLMs

使用OpenAI兼容的API開發基於AI的應用程序

在不需要昂貴硬件的情況下運行個人項目的AI模型

利用LLMs進行文本生成、聊天機器人和代碼生成等任務

無羽 的核心功能

無限個人使用*

不斷增長的社區模型列表,每週更新

完全兼容OpenAI的API訪問

訪問高達15B模型(基本版)/ 72B模型(高級版)

私密、安全和匿名使用 - 不記錄日誌

無羽 常見問題

無羽是什麼?

無羽是一個AI模型提供者,為我們的訂閱者提供不斷擴展的Hugging Face模型庫。 無羽:少麻煩,少努力。立即開始。

費用是多少?

我們提供兩種價格計劃,每月10美元和25美元。 如果並發限制對於真正的個人使用來說太限制,請通過我們的<a>discord</a>與我們聯繫。

我的日誌被存儲嗎?

不,作為一個注重隱私的服務,我們不會記錄您的任何聊天、提示或完成內容。

支持哪種模型架構?

目前,我們支持基於LLaMA-3的模型,包括LLaMA-3和QWEN-2。 請注意,QWEN-2模型僅支持最多16,000個上下文長度。 我們計劃很快將更多架構添加到我們的支持列表中。

如何添加新模型?

在我們的<a>discord</a>上聯繫我們。 我們會不斷添加新模型,使其與可兼容架構的Hugging Face上的所有公開可用模型相適應,隨著我們的發展,我們的目標是自動化這一過程。

無限有多無限?

只要您保持訂閱狀態,模型使用沒有時間限制。 為了確保公平的個人帳戶使用,同時請求根據您選擇的計劃進行限制。 輸出速度為每秒10-40個標記,具體取決於模型和提示大小。

如何聯繫你們?

加入我們的<a>discord</a>或在<a>r/SillyTavernAI</a>找到我們

你們運行量化模型嗎?

是的,我們使用FP8量化。 在與社區協商後,我們發現這種方法在顯著提高推理速度的同時保持輸出質量。

你們是如何運行這麼多模型的?

在平台的核心是我們的自定義推理堆棧,我們可以動態地運行多個模型。

使用無羽的用戶

AI開發人員

研究人員

愛好者

尋找價格實惠且易於訪問的LLM解決方案的個人和企業