Featherless

Featherless - Servidor LLM sem penas

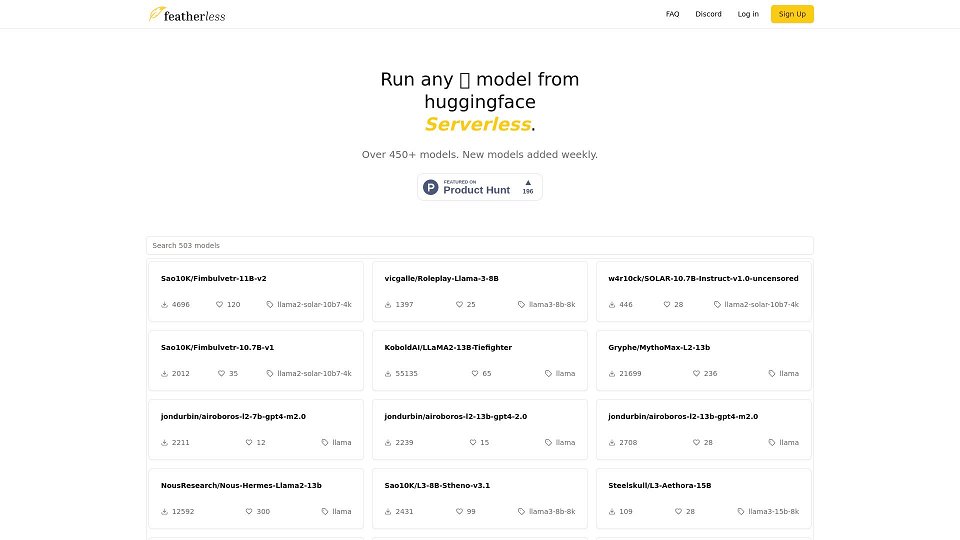

Featherless - Os mais recentes modelos LLM, sem servidor e prontos para usar sob demanda.

Introdução de Featherless

Featherless é um provedor de modelos de IA que oferece acesso baseado em assinatura a uma ampla variedade de grandes modelos de linguagem (LLMs) hospedados no Hugging Face. Ele fornece uma plataforma sem servidor onde os usuários podem interagir com esses modelos por meio de uma API compatível com OpenAI. A Featherless se concentra em fornecer acesso econômico a LLMs poderosos, incluindo LLaMA-3 e QWEN-2, com altas velocidades de inferência graças à quantização FP8. Eles priorizam a privacidade do usuário, não registrando nenhuma interação do usuário. A Featherless também apoia e contribui para o desenvolvimento de IA de código aberto, com uma parte de sua receita sendo destinada ao treinamento e escalonamento de modelos multilíngues e acessíveis.

Casos de Uso de Featherless

Acessar e experimentar vários LLMs

Desenvolver aplicativos com IA usando uma API compatível com OpenAI

Executar modelos de IA para projetos pessoais sem a necessidade de hardware caro

Utilizar LLMs para tarefas como geração de texto, chatbots e geração de código

Recursos principais de Featherless

Uso pessoal ilimitado*

Lista cada vez maior de modelos da comunidade, atualizados semanalmente

Acesso completo à API compatível com OpenAI

Acesso a modelos de até 15B (Básico) / 72B (Premium)

Uso privado, seguro e anônimo - sem registros

Perguntas Frequentes sobre Featherless

O que é o Featherless?

Featherless é um provedor de modelos de IA que oferece aos nossos assinantes acesso a uma biblioteca em constante expansão de modelos Hugging Face. Featherless: Menos problemas, menos esforço. Comece agora.

Quanto custa?

Oferecemos dois planos de preços a $10 e $25 por mês Se os limites de concorrência forem muito restritivos para uso pessoal genuíno, entre em contato conosco através do nosso <a>discord</a>

Meus registros são armazenados?

Não. Como um serviço focado em privacidade, não registramos nenhum de seus chats, prompts ou conclusões.

Qual arquitetura de modelo é suportada?

Atualmente, suportamos modelos baseados em LLaMA-3, incluindo LLaMA-3 e QWEN-2. Observe que os modelos QWEN-2 são suportados apenas até o comprimento do contexto de 16.000. Planejamos adicionar mais arquiteturas à nossa lista de suporte em breve.

Como faço para adicionar novos modelos?

Entre em contato conosco através do nosso <a>discord</a>. Continuamos a adicionar novos modelos à medida que eles ficam disponíveis no Hugging Face. Conforme crescemos, pretendemos automatizar esse processo para abranger <em>todos</em> os modelos do Hugging Face publicamente disponíveis com arquitetura compatível.

Quão ilimitado é ilimitado?

Desde que você permaneça assinado, não há limite de tempo para o uso do modelo. Para garantir o uso justo da conta individual, as solicitações simultâneas são limitadas de acordo com o plano selecionado. A saída é entregue a uma velocidade de 10-40 tokens por segundo, dependendo do modelo e do tamanho do prompt.

Como posso entrar em contato?

Junte-se ao nosso <a>discord</a> ou nos encontre no <a>r/SillyTavernAI</a>

Vocês estão executando modelos quantizados?

Sim, usamos quantização FP8. Após consultar a comunidade, descobrimos que essa abordagem mantém a qualidade da saída enquanto melhora significativamente as velocidades de inferência.

Como vocês conseguem executar tantos modelos?

No centro da plataforma, está nossa pilha de inferência personalizada, na qual podemos dimensionar dinamicamente

Usuários que usam Featherless

Desenvolvedores de IA

Pesquisadores

Hobbyistas

Indivíduos e empresas em busca de soluções LLM acessíveis e acessíveis